【一Dian算法第一期】王兴刚导师揭秘神经网络

【一Dian算法第一期】王兴刚导师揭秘神经网络

文| 预备队员 谭竣

2021年10月22日晚8:15,在华中科技大学东九教学楼B102教室,Dian团队“一Dian算法”系列讲座第一期正式开始,电信学院副教授、Dian团队导师王兴刚老师应邀为队员们分享AI基础算法。

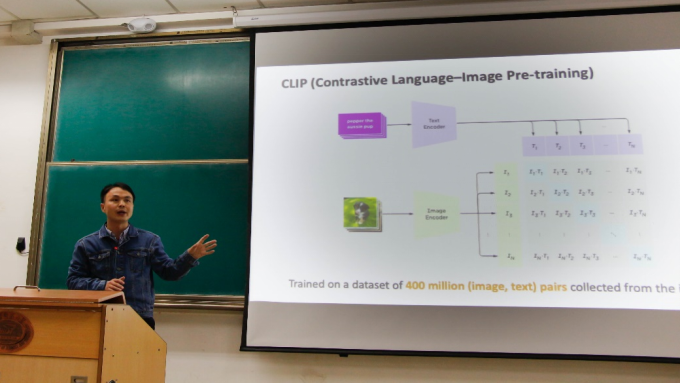

开场,王兴刚老师以几张简单图片为引,展示使用算法检测图片中物体数量和种类的识别结果,引出对CLIP算法(Contrastive Language-Image Pre-training)的介绍。CLIP算法使用大量成对的文本和图片训练,能够在开放场景中比较准确地识别出相似度最高的文本和图片对。

图1 王兴刚老师为大家讲解CLIP算法

随后,王兴刚老师揭开了AI算法的“神秘”面纱,层层递进,向我们介绍了其下的支持理论和数学推导。王兴刚老师先从AI算法的主体——神经网络入手,依次讲解了激活函数、前向传播和损失函数。最基本的神经元是由一个线性函数和一个非线性的激活函数组成,激活函数可以使输入超过一定标准时才会产生输出,并且调控输出的范围。n维向量的初始数据通过前向传播经过多层神经处理获得输出,但是输出结果和真实结果是存在偏差的,这时引入了损失函数的概念,损失函数值越大,说明神经网络的输出结果越远离我们的期望。怎么通过减少损失函数值来使输出结果更靠近真实结果呢?王兴刚老师给出了一个便于理解的比喻:一个蒙着眼睛的人在一片山岭中尝试寻找地势较低的山谷——这便是梯度下降。而实现梯度下降的方法就是与前向传播相对应的反向传播,也就是通过预测结果,向前倒导每一层神经元的参数。反向传播涉及到了微分和偏微分、递归等数学原理,鉴于时间问题,王兴刚老师并没有深入讲解,他提到,这里并不是算法的难点,很多算法框架已经为我们封装好了计算过程。

接下来,王兴刚老师展示了部分算法实例代码,指出AI算法非常重要的一个环节是调整参数,参数的选择会很大程度上影响算法的准确度和性能。此外,王兴刚老师展示了如今AI算法的实际应用,比如物体检测、图像语义分割等等。

最后,王兴刚老师以三点总结收尾:神经网络的数学形式非常简洁优美;反向传播的优化方式通用且高效;在有监督大数据、高性能计算条件下,神经网络表现出强大的拟合能力,并在图像识别等AI问题上取得了巨大的成功。这三点完美点出了今晚的算法分享内容,也说明了AI算法的优势和成果。一Dian算法系列讲座第一期圆满结束,感谢王兴刚老师深入浅出的精彩分享!